ChatGPTż╬╚ŠŲ│öüŠÅČ╚żžż╬źżź¾źčź»ź╚Īó1╦³Ė─ż╬GPUż¼ź│źóČ\Įčż╦

╩╣ż▒żąż╩ż¾żŪżŌ┼·ż©żŲż»żņżļChatGPTż¼ÅRų`żĄżņżŲżżżļż¼Īóż│ż╬AIĪ╩źŪźŻĪ╝źūźķĪ╝ź╦ź¾ź░Ī╦żŽĪóż│żņż▐żŪż╬AIĪ╩ĄĪ│Ż│žØ{Ī╦ż╚żŽĮj(lu©░)żŁż»░Ńż”ĪŻż│żņż▐żŪżŽØŖ─Ļ├ō²ŗż╬└ņ├ōAIż└ż├ż┐ż╬ż╦×┤żĘżŲĪóChatGPTż╦╗╚ż’żņżļĮj(lu©░)æä╠ŽĖ└ĖņźŌźŪźļĪ╩LLMĪ╦żŽ└@├ōAIż╦ż─ż╩ż¼żļČ\Įčż└ż½żķżŪżóżļĪŻż│ż╬╝┬ĖĮż╬ż┐żßż╦żŽĘÕ░Ńżżż╬¾Hż»ż╬└čŽ┬▒ķōQ╚ŠŲ│öüź┴ź├źūĪ╩GPUĪ╦ż¼ØŁ═ūżŪżóżļĪŻż│ż│ż╦┐Ęż┐ż╩╚ŠŲ│öüęŖ═ūż¼Ö┌ż▐żņżļż│ż╚ż╦ż╩żļĪŻ

Įj(lu©░)æä╠ŽĖ└ĖņźŌźŪźļĪ╩LLMĪ╦ż“│žØ{źŌźŪźļż╚żĘżŲ╗╚ż”ż┐żßż╦żŽĪó“£═Ķż╩żķ│žØ{ż╦┐¶ź½ĘŅżŌż½ż½żļż┐żßĪó¾Hż»ż╬AIźĮźšź╚ź”ź©źó│½╚»ŪvżŽLLMż╬│½╚»ż“żóżŁżķżßżŲżżż┐ĪŻżĘż½żĘĪó«Ć╩┬š`żŪGPUż╩ż╔╩┬š`└čŽ┬▒ķōQź┴ź├źūż“Įj(lu©░)╬╠ż╦╗╚ż├żŲ│žØ{ż╣żņżą╣ń═²┼¬ż╩╗■┤ųżŪ║čżÓżĶż”ż╦ż╩żļĪŻżĮż╬±T▓╠Ö┌ż▐żņż┐ż╬ż¼ChatGPTż╚żżż”Ö┌└«AIż└ĪŻMicrosoftż¼Įą½@ż╣żļĖ”ē|│½╚»┤ļČ╚OpenAI╝ęż¼│½╚»Īóżżż▐ÅRų`ż“ĮĖżßżŲżżżļĪŻ

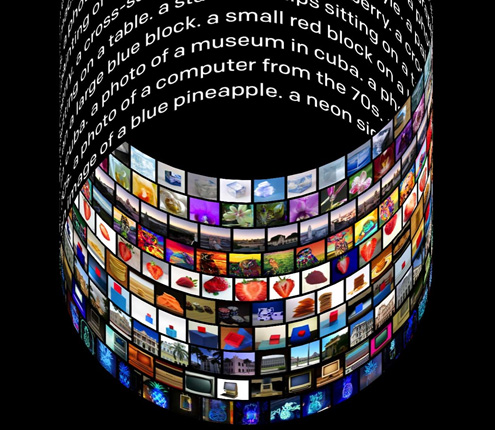

┐▐1ĪĪOpenAIż¼│½╚»żĘż┐źŲźŁź╣ź╚ż“Ų■╬üż╣żļż└ż▒żŪ═▀żĘżż▓Ķ楿¼įużķżņżļAIż╬DALLÄźEĪ╩▓Ķ▓╚ż╬ź└źĻż╚╚»▓╗Ī╦ĪĪĮąųZĪ¦OpenAI

źŽĪ╝ź╔ź”ź©źóŖõż½żķChatGPTż“╝┬ĖĮż╣żļż┐żßż╦żŽĪó│žØ{żĄż╗żļż”ż©żŪGPUĪ╩ź░źķźšźŻź├ź»ź╣źūźĒź╗ź├źĄĪ╦ż¼Įj(lu©░)╬╠ż╦ØŁ═ūż╚ż╩żļż│ż╚żŽ═Ų░ūż╦„[楿ŪżŁżļĪŻ║ŪŖZźĻźĻĪ╝ź╣żĘĪóÅB¼öż╦ż╩ż├żŲżżżļChatGPT-3ż╦żŽ1750▓»źčźķźßĪ╝ź┐żŪ│žØ{żĄż╗ż┐źŌźŪźļż¼┴╚ż▀╣■ż▐żņżŲżżżļżŌż╬ż╬ĪóChatGPTż“╗╚ż├żŲż▀ż┐══Ī╣ż╩źņź▌Ī╝ź╚ż“Ė½żļż╚ĪóØŁż║żĘżŌ┘ć│╬żŪżŽż╩żżż╚żżż”ĪŻż│ż╬ż┐żßĪó2023ŃQ├µż┤żĒż╦źĻźĻĪ╝ź╣żĄżņżļ╝Ī└ż┬Õ╚Ūż╬ChatGPT-4żŪżŽżĄżķż╦¾Hż»ż╬źčźķźßĪ╝ź┐żŪ│žØ{żĄżņżŲżżżļż│ż╚ż¼═Į„[żĄżņżļĪŻĖĮ║▀ż╬ChatGPT-3ż“│žØ{żĄż╗żļż┐żßż╦Nvidiaż╬GPUż¼1╦³Ė─żŌ╗╚ż’żņżŲżżżļż╚ż▀żķżņżŲżżżļĪŻż╚żżż”ż│ż╚żŽĪó║ŻĖÕż╬ChatGPTż╬│½╚»ż╦żŽżĄżķż╦¾Hż»ż╬GPUż¼ØŁ═ūż╚ż╩żļż│ż╚ż“┐ā║ȿʿŲżżżļĪŻ

NvidiażŽĪóźŪĪ╝ź┐ź╗ź¾ź┐Ī╝Ė■ż▒GPUż╬ęŖ═ūżŽ╦ĶŃQ23.5%ż╬ź┌Ī╝ź╣żŪ└«─╣żĘżŲż¬żĻĪó2022ŃQŗī3╗═╚Š┤³ż╦żŽØiŃQŲ▒┤³╚µ30%└«─╣żĘż┐ĪŻ

ĀCŪ“żż╝┬┘xż╚żĘżŲĪóä▌╣±ż╬ź©źņź»ź╚źĒź╦ź»ź╣źßźŪźŻźóż╬Fierce ElectronicsżŽChatGPTż╦ż╔ż╬żĶż”ż╩ź│ź¾źįźÕĪ╝ź┐ż“╗╚ż├żŲżżżļż╬ż½ż“╩╣żżżŲż▀ż┐ż╚żżż”Ī╩╗▓╣═½@╬┴1Ī╦ĪŻ╩ųż├żŲżŁż┐┼·ż©żŽż▐ż║ĄĪ│Ż│žØ{ż╬└Ō£½ż½żķ╗Žż▐ż├ż┐Ī©

Ī”ChatGPTżŽĪó╩┬š`ĮĶ═²├ōż╦Įj(lu©░)╬╠ż╬GPUż“×óż©ż┐╩¼Ügź│ź¾źįźÕĪ╝źŲźŻź¾ź░æųżŪ┴÷żļĄĪ│Ż│žØ{źŌźŪźļĪ”ChatGPTż╦╗╚ż’żņżļźŽĪ╝ź╔ź”ź©źóżŽØŖÖzż╩żŌż╬ż└ż¼ĪóNvidiaż╬GPUż¼żĶż»╗╚ż’żņżŲż¬żĻĪóŲ▒╝ęż╬źĮźšź╚ź”ź©źóCUDAż¼źĄź▌Ī╝ź╚żĘżŲżżżļĪŻ

Ī”ChatGPTż╬żĶż”ż╩Įj(lu©░)æä╠ŽźŪźŻĪ╝źūźķĪ╝ź╦ź¾ź░ż“│žØ{ż╣żļż┐żßż╬źżź¾źšźķż╚żĘżŲ▐k╚╠┼¬ż╩ź»źķź”ź╔┤─ČŁżŪżóżļAWSżõGCPĪóAzureż╩ż╔ż¼żóżļĪŻ

Ī”┐õébżŽĪóĄĪ│Ż│žØ{żĄżņż┐źŌźŪźļż“╗╚ż├żŲĪó┐ʿʿżźŪĪ╝ź┐ż“═Į▒Rż╣żļż│ż╚ĪŻChatGPTżŪżŽĪóŲ■╬üźŪĪ╝ź┐ż╦×┤żĘżŲĪó┐═┤ųż╬żĶż”ż╩źŲźŁź╣ź╚ż“Ö┌└«ż╣żļż┐żßż╦╗╚ż’żņżļĪŻ

żĮż╬żóż╚żĄżķż╦É║öü┼¬ż╦Nvidia░╩│░ż╬GPUżŌ╗╚ż├żŲżżżļż╬ż½ż“æ®ż═ż┐ż╚ż│żĒĪó╝Īż╬żĶż”ż╩╩ųĄ£ż“żĘż┐ż╚żżż”Ī©

Ī”Įø(j©®ng)═ĶżŽż█ż½ż╬ź┘ź¾ź└Ī╝ż╬GPUżŪChatGPTż╩ż╔ż╬│žØ{ż“żŪżŁżļż└żĒż”ż¼ĪóĖĮ║▀żŽNvidiaż╬GPUż¼╣Łż»╗╚ż’żņżŲżżżļĪŻCUDAźĄź▌Ī╝ź╚ż¼żóżļż½żķż└ĪŻCUDAżŽNvidiaż╬GPUż“Ė·╬©żĶż»╗╚ż”ż┐żßż╦ØŁ═ūż╩╩┬š`ĮĶ═²źūźķź├ź╚źšź®Ī╝źÓżŪżóżĻźūźĒź░źķź▀ź¾ź░źŌźŪźļżŪżóżļĪŻĪ”ChatGPTż“│½╚»żĘż┐OpenAI╝꿎Īó┐ʿʿżAIČ\ĮčżõźŌźŪźļż“│½╚»├µżŪĪóźŌźŪźļż“▓■╬╔ż╣żļż┐żßż╦Š’ż╦┐ʿʿżźŽĪ╝ź╔ź”ź©źóĪ╩╚ŠŲ│öüź┴ź├źūĪ╦żõźĮźšź╚ź”ź©źóż“╗ŅżĘżŲżżżļĪŻ

Ī”ChatGPTż“╬Ńż©żą1╦³Ė─ż╬Nvidiaż╬GPUż╬żĶż”ż╩Įj(lu©░)╬╠ż╬GPUż“╗╚ż├żŲ│žØ{żĄż╗żļż│ż╚ż¼żŪżŁżļĪŻż┐ż└żĘĪóÉ║öü┼¬ż╩źżź¾źūźĻöĄ(sh©┤)╦ĪżõŲ■Š}żŪżŁżļźĻźĮĪ╝ź╣ż╦żĶż├żŲ┘ć│╬ż╩GPUż╬┐¶żŽ╩čż’żĻĪó│žØ{żĄż╗żļźŪĪ╝ź┐╬╠żõ│žØ{źŌźŪźļż╦żĶż├żŲżŌ╩čż’żļĪŻ

Nvidiaż╬żĶż”ż╩GPUżŪżŽż╩ż»ĪóAI│žØ{ż“ų`┼¬ż╚żĘż┐AIź┴ź├źūĪ╩Įj(lu©░)╬╠ż╦╩┬š`ĮĶ═²żŪżŁżļ└čŽ┬▒ķōQ▀_ż╚Īó▒ķōQ±T▓╠żõ─_ż▀źŪĪ╝ź┐ż“ĄŁŹ{ż╣żļźßźŌźĻż“ĮĖ└čżĘż┐ICĪ╦ż¼żóżņżą╚ŠŲ│öüźßĪ╝ź½Ī╝żŽĮj(lu©░)æä╠ŽĖ└ĖņźŌźŪźļż╬Ö┌└«AIĖ■ż▒ż╬┐Ę▌xŠņż╦─®└’żŪżŁżļĪŻżĮżĘżŲCUDAż╬żĶż”ż╩źūźĒź░źķź▀ź¾ź░żĘżõż╣żż┤─ČŁż╬źūźķź├ź╚źšź®Ī╝źÓżŌÖ┌ż▀Įąż╣?ji©”)Ł═ūż¼żóżļĪŻChatGPTżŽĪóŲ³╦▄żŌ║Żż½żķīÖ╠÷▓─ē”ż╩┤─ČŁż¼żŪżŁżļż│ż╚ż“┐āżĘżŲżżżļĪŻ

╗▓╣═½@╬┴

1. Matt Hamblen, "Update: ChatGPT Runs 10K Nvidia Training GPUs with Potential for Thousands More", Fierce Electronics (2023/02/11)