CerebrasĪó4├¹ź╚źķź¾źĖź╣ź┐ż╬ŗī3└ż┬Õź”ź¦Ī╝źŽź╣ź▒Ī╝źļAIź┴ź├źūż“│½╚»

Cerebras Systems╝꿎Īó4├¹ź╚źķź¾źĖź╣ź┐ż“ĮĖ└čżĘż┐ź”ź¦Ī╝źŽź╣ź▒Ī╝źļż╬AIźóź»ź╗źķźņĪ╝ź┐ź┴ź├źūĪųWSE-3Īūż“│½╚»żĘż┐ĪŻ300mmź”ź¦Ī╝źŽż½żķ21cm│čż╦└┌żĻŲDż├ż┐╚ŠŲ│öüżŪĪóØiövż╬WSE-2Ī╩╗▓╣═½@╬┴1Ī╦żŪż╬7nmż½żķ5nmźūźĒź╗ź╣ż“ŠW(w©Żng)├ōżĘżŲĮĖ└č┼┘ż“æųż▓ż┐ĪŻż│ż╬ź”ź¦Ī╝źŽź╣ź▒Ī╝źļICż“┴╚ż▀╣■ż¾ż└AIź│ź¾źįźÕĪ╝ź┐ĪųCS-3Īūż“64±ś┴╚ż▀╣■żÓĪųCondor Galaxy 3Īūż“└’ŠS┼¬źčĪ╝ź╚ź╩Ī╝żŪżóżļG42ż╚Č”Ų▒żŪ│½╚»├µżŪżóżļĪŻ

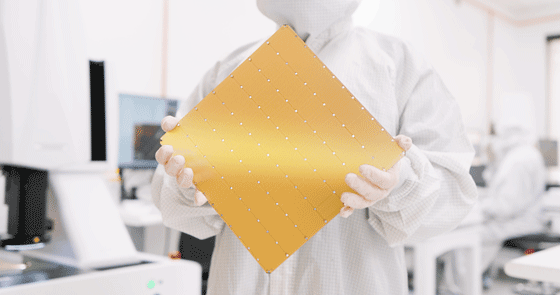

┐▐1ĪĪŗī3└ż┬Õż╬ź”ź¦Ī╝źŽź╣ź▒Ī╝źļICĪųWSE-3Īūż“│½╚»ĪĪĮąųZĪ¦Cerebras Systems

ź”ź¦Ī╝źŽź╣ź▒Ī╝źļICĪųWSE-3Īūż“┼ļ║▄żĘż┐AIź│ź¾źįźÕĪ╝ź┐CS-3ż╬└Łē”żŽĪóż│żņż▐żŪ║Ū╣Ōż╬CS-2ż╚Ų▒żĖŠ├õJ┼┼╬üĪóŲ▒żĖ▓┴│╩żŪ╚µż┘żļż╚└Łē”żŽ2Ū▄ż╦ż╩ż├żŲżżżļż╚żżż”ĪŻż│ż╬ź│ź¾źįźÕĪ╝ź┐CS-3żŽĪó║ŪżŌĄĮj(lu©░)ż╩AIźŌźŪźļż“│žØ{żĄż╗żļż│ż╚ż“ų`┼¬ż╚żĘż┐ź▐źĘź¾żŪĪó║ŪĮj(lu©░)24├¹źčźķźßĪ╝ź┐ż╬AIźŌźŪźļż“│žØ{żĄż╗żļż│ż╚ż“┴└ż├żŲżżżļĪŻŲ▒╝ęż╬ź”ź¦Ī╝źŽź╣ź▒Ī╝źļAIź┴ź├źūżŽĪóŗī1└ż┬Õż¼16nmĪ╩╗▓╣═½@╬┴2Ī╦Īóŗī2└ż┬Õ7nmĪóŗī3└ż┬Õż¼5nmż╚żõż├żŲżŁż┐ĪŻ5nmźūźĒź╗ź╣ż╬ICźšźĪź”ź¾ź╔źĻżŽTSMCż└ż╚Īóż│ż╬AIź┴ź├źūż“┼ļ║▄żĘż┐ź│ź¾źįźÕĪ╝ź┐ż“?y©żn)æ║ŅżĘżŲżżżļG42ż¼ź╦źÕĪ╝ź╣źĻźĻĪ╝ź╣żŪĮęż┘żŲżżżļĪ╩╗▓╣═½@╬┴3Ī╦ĪŻ

ź”ź¦Ī╝źŽź╣ź▒Ī╝źļICż╬ź┴ź├źūĀC└迎46,225mm2ż╚ĄĮj(lu©░)żŪĪóź╣źčĪ╝ź╣└■Ę┴┬Õ┐¶Ī╩ź╝źĒż╬¾HżżšÅ╣įš`Ī╦ż╦║Ū┼¼▓ĮżĄżņż┐90╦³ź│źóż¼ĮĖ└迥żņżŲżżżļĪŻAIź│ź¾źįźÕĪ╝ź┐ż╚żĘżŲż╬└Łē”żŽ125 Peta FLOPSĪ╩1PetażŽ10ż╬15ŠĶĪ╦Ī󟬟¾ź┴ź├źūźßźŌźĻż╬═Ų╬╠żŽ44 GBĪó│░ŗźßźŌźĻĪ╩HBMĪ╦żŽ1200 GBżŪĪóźßźŌźĻż╬źąź¾ź╔╔²żŽ21 Peta Bytes/sż╚ż╩ż├żŲżżżļĪŻ

CerebrasżŽż▐ż┐ĪóAIźóź»ź╗źķźņĪ╝ź┐CS-3ż“│žØ{├ōż╦╗╚żżĪóQualcommż╬ź»źķź”ź╔AI 100 Ultraż“┐õéb├ōż╦AIż“╗╚ż©żąĪó╠¾10Ū▄ż╬ź│ź╣ź╚Ī”źčźšź®Ī╝ź▐ź¾ź╣ż¼įu(p©¬ng)żķżņż┐ż╚żĘżŲżżżļĪŻ

źóźųź└źėż“Ą“┼└ż╚ż╣żļAIź│ź¾źįźÕĪ╝ź┐┤ļČ╚ż╬G42╝꿎ĪóCerebrasż╬AIź┴ź├źūWSE-3ż“┼ļ║▄żĘż┐AIźóź»ź╗źķźņĪ╝ź┐ĪųCS-3Īūż“64±ś╩┬ż┘ż┐AIź│ź¾źįźÕĪ╝ź┐ĪųCondor Galaxy 3Īūż“╗Ņ║ŅżĘż┐ĪŻCG 3ż╦żŽ╠¾5800╦³Ė─ż╬AIż╦║Ū┼¼▓ĮżĘż┐ź│źóż“?y©żn)óż©Ī?6 Exa FLOPSĪ╩Floating Operations Per SecondĪ╦ż╚żżż”«Ć╣Ō└Łē”ż“╚»Ä¦ż╣żļż╚Ė½└čżŌż├żŲżżżļĪŻExażŽ10ż╬18ŠĶż“┴T╠Żż╣żļ├▒░╠ĪŻ

2023ŃQ11ĘŅĖĮ║▀ż╦ż¬ż▒żļ└ż─cż╬ź╣Ī╝źčĪ╝ź│ź¾źįźÕĪ╝ź┐źķź¾źŁź¾ź░TOP500żŪ║ŪżŌ╣ŌÅ]ż╬ź╣źčź│ź¾żŽĪóä▌(sh©¼)Oakridge ╣±╬®Ė”ē|ĮĻż╬1.1 Exa FLOPSżŪżóżļż½żķĪóCS-3żŽżĮż╬1ĘÕæųż╬└Łē”ż╚ż╩żļĪŻż┴ż╩ż▀ż╦Ų³╦▄ż╬╔┘▀tżŽ║“ŃQż╦¶öżŁŗī4░╠ż╬0.44 Exa FLOPSż╚ż╩ż├żŲżżżļĪŻ

ĪųCondor Galaxy 3Īūż“╗╚ż©żąĮj(lu©░)æä╠ŽĖ└ĖņźŌźŪźļLlama-70BĪ╩700▓»źčźķźßĪ╝ź┐Ī╦ż“│žØ{żĄż╗żļż╬ż╦ż’ż║ż½┐¶Ų³żŪ║čżÓż╚żżż”ĪŻ1750▓»źčźķźßĪ╝ź┐ż╬LLMżŪżóżļGPT-3ż“Nvidiaż╬GPUżŪżóżļA100żŪżŽ│žØ{ż╣żļż╬ż╦300Ų³ż½ż½ż├ż┐ż╚Ė└ż’żņżŲżżżļĪŻ

ż│żņż▐żŪż╬Condor Galaxy 1ż╚2żŽĪóä▌(sh©¼)╣±ź½źĻźšź®źļź╦źó䔿╦└▀ÅøżĄżņżŲżżżļż¼ĪóCondor Galaxy 3żŽźŲźŁźĄź╣䔟└źķź╣ż╦└▀ÅøżĄżņżļ═Į─Ļż└ż╚żżż”ĪŻ

Cerebrasż╬CS-1ż╚CS-2ż╬AIźóĪ╝źŁźŲź»ź┴źŃżŽĪó“£═Ķż╬źšź®ź¾ź╬źżź▐ź¾Ę┐ź│ź¾źįźÕĪ╝źŲźŻź¾ź░żŪżŽż╩ż»Īóź╦źÕĪ╝źķźļź═ź├ź╚ź’Ī╝ź»ż╬ź’Ī╝ź»źšźĒĪ╝ż╚Ų▒══ĪóźŪĪ╝ź┐źšźĒĪ╝ź│ź¾źįźÕĪ╝źŲźŻź¾ź░żŪżóżļĪŻCS-3żŌżĮż╬źóĪ╝źŁźŲź»ź┴źŃż“║╬├ōżĘżŲżżżļż╚╗ūż’żņżļż¼Īó£½żķż½ż╦żĘżŲżżż╩żżĪŻ

╗▓╣═½@╬┴

1. Īų7nmźūźĒź╗ź╣żŪ×æļ]żĘż┐ź”ź¦Ī╝źŽæä╠Žż╬ĄĮj(lu©░)ż╩AIź┴ź├źūĪūĪóź╗ź▀ź│ź¾ź▌Ī╝ź┐źļ (2021/04/28)

2. ĪųCerebras╝ęĪ󟔟¦Ī╝źŽæä╠Žż╬AIź┴ź├źūż“╝┬äóżĘż┐ź│ź¾źįźÕĪ╝ź┐ż“╚»ŪõĪūĪóź╗ź▀ź│ź¾ź▌Ī╝ź┐źļ (2019/12/20)

3. "G42 and Cerebras Break Ground on Condor Galaxy 3, an 8 exaFLOPs AI Supercomputer", G42 (2024/03/13)